Der lange Weg der KI

Viele Menschen sind erst in den letzten Jahren durch frei verfügbare Sprachmodelle mit KI in Berührung gekommen. Tatsächlich gibt es diese Technologie jedoch schon seit den 1950er-Jahren. In den Jahrzehnten dazwischen schwankte ihre Beliebtheit stark, mit zwei grossen „KI-Wintern“. In diesem Artikel zeichnen wir die Geschichte der KI nach und zeigen, wie sie zum heutigen Boom geführt hat.

Frühe Jahre: Perzeptronen und symbolische KI

Zurück in die 1950er. Wer hat KI eigentlich erfunden? Realistisch betrachtet war es Teamarbeit. Mehrere Forscher haben bereits ein Jahrzehnt an den Grundlagen gearbeitet. Doch Norbert Wiener, Alan Turing und Claude Shannon legten mit ihren Theorien den Grundstein.

Das bekannteste Element dieser Anfangszeit ist der Turing-Test. Doch auch Frank Rosenblatt und sein Perzeptron prägten die Entwicklung stark. 1958 stellte er das Modell vor: ein echtes neuronales Netz, aber nur mit einer Schicht. Es konnte einfache binäre Aufgaben lösen. Aus heutiger Sicht wirkt das simpel, doch Rosenblatt sah darin enormes Potenzial – und er war nicht allein.

Die Euphorie hielt jedoch nicht lange. Marvin Minsky und Seymour Papert – frühere Kollegen Rosenblatts – veröffentlichten 1969 ein kritisches Buch “Perceptrons”. Darin zeigten sie die Grenzen des Perzeptrons auf, etwa dass es komplexe Aufgaben nicht bewältigen konnte. Mit dieser Veröffentlichung begann der erste KI-Winter und Rosenblatts Arbeit verlor an Schwung.

Aufstieg der Expertensysteme und die KI-Winter

Ein sogenannter KI-Winter – bisher zweimal in der Geschichte – bezeichnet eine längere Phase, in der die Forschung stagniert, Gelder knapp werden und sich die Ausrichtung des gesamten Feldes verschiebt. Das Buch von Marvin Minsky und Seymour Papert war ein direkter Auslöser für den ersten KI-Winter, der die 1970er-Jahre prägte. Trotz massiver Kürzungen forschten Wissenschaftler weiter, und auch die Öffentlichkeit blieb optimistisch, was die Entwicklung künstlicher Intelligenz betraf.

Mit der Zeit traten jedoch die Grenzen der neuen Systeme deutlich zutage. Sie arbeiteten mit minimaler Rechenleistung, hatten keine Chance auf Skalierung und liessen sich nur schwer mit ausreichend Daten „füttern“. Um diese Hürden zu überwinden, musste eine neue Generation von Rechnern entstehen. Japan nahm diese Herausforderung 1982 mit den Projekten der „Fünften Generation“ an. Ziel war es, Computer zu bauen, die Gespräche führen, logisch argumentieren und hochwertige maschinelle Übersetzungen liefern konnten. Zwar gelang es nicht, die perfekte KI zu schaffen, doch Japans Vorstoss brachte auch die USA und Grossbritannien dazu, massiv in KI zu investieren – das Ende des ersten Winters.

In derselben Zeit nutzte Richard Greenblatt den Aufschwung der Expertensysteme: Maschinen, die präzise Antworten liefern konnten, allerdings nur in einem klar abgegrenzten Themengebiet. Seine Lisp-Maschinen waren speziell für Lisp-Operationen entwickelt und leistungsfähig genug, um komplexere KI-Anwendungen zu nutzen. Das Unternehmen hinter diesen Rechnern spaltete sich später in zwei Konkurrenten, deren Rivalität beide Seiten dazu antrieb, ihre Produkte zu verbessern und die KI-Geschichte weiterzuschreiben.

So fruchtbar diese Ära auch erscheinen mag, sie konnte den zweiten Winter nicht verhindern. In den 1990er-Jahren brach das Feld erneut teilweise zusammen: Hunderte Firmen mussten schliessen, die Finanzierung versiegte, und die wenigen Überlebenden verlagerten ihren Fokus auf andere Bereiche.

Rückkehr der neuronalen Netze: Backpropagation & Deep Learning

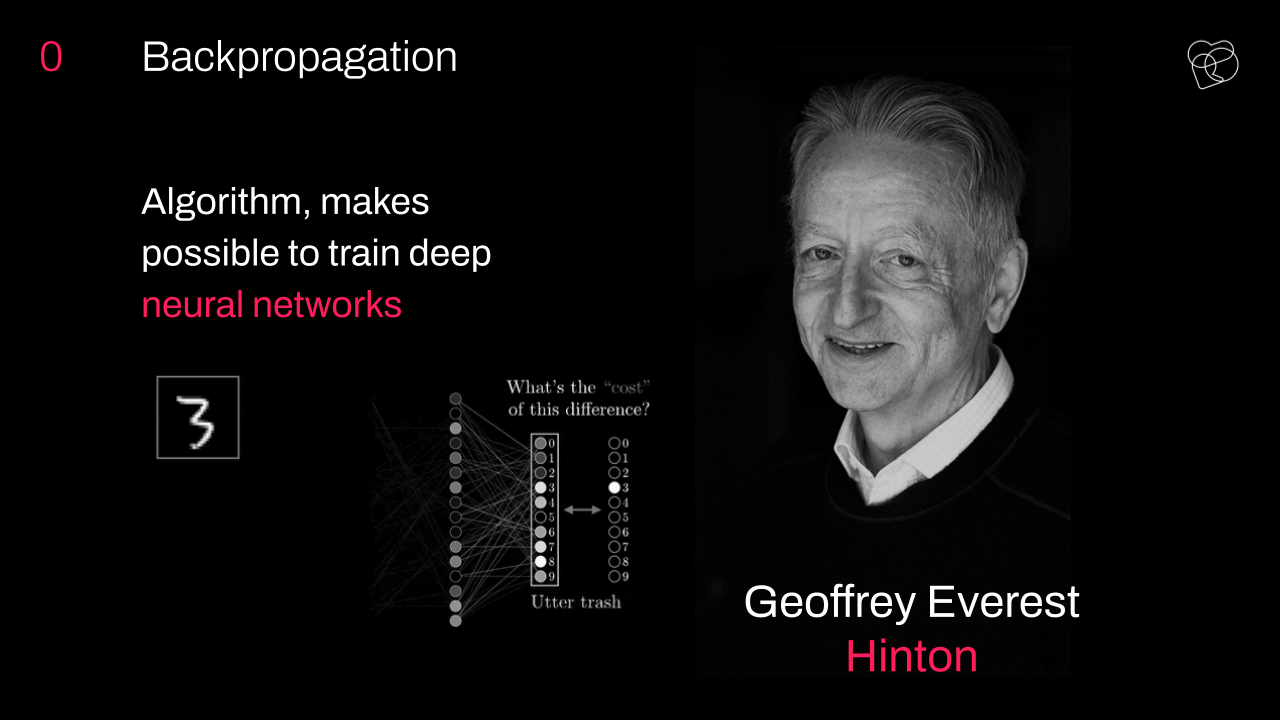

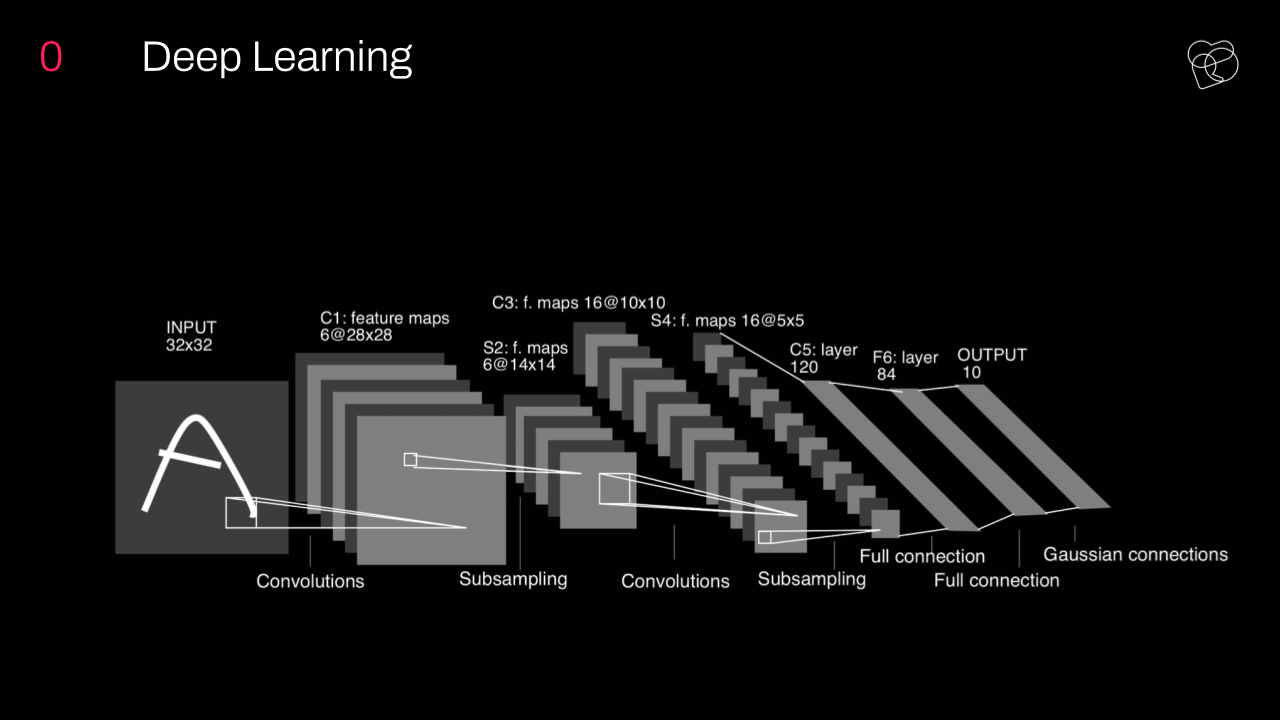

Neuronale Netze lagen lange auf Eis – nicht zuletzt wegen der Kritik von Minsky und Papert und wegen ihres enormen Rechenbedarfs. In den 2000er-Jahren kam es jedoch zu einem neuen Aufschwung. Bessere Hardware, eine neue Generation von GPUs und der erfolgreiche Einsatz des Backpropagation-Verfahrens spielen eine entscheidende Rolle. Backpropagation, bereits 1986 entwickelt, revolutionierte das Training von KI-Systemen: schneller, stabiler und verlässlicher.

Nach dem Winter der 1990er-Jahre erlebte die KI-Geschichte in den 2000ern einen deutlichen Schub. Ein zentraler Faktor war die Verfügbarkeit von Big Data. Vorbereitete und geordnete Datensätze ermöglichen es neuronalen Netzen, in einem ganz anderen Tempo zu wachsen und sich zu verbessern. Einen grossen Sprung brachte ImageNet – eine riesige Datenbank, die mit drei Millionen Bildern gestartet und speziell für Trainingszwecke geschaffen wurde.

Dank ImageNet erzielten Netze immer bessere Ergebnisse bei der Objekterkennung, gekrönt 2012 durch AlexNet, das als erstes prominentes Deep-Learning-Modell einen echten Durchbruch schaffte.

Hinzu kam der Beitrag von Unternehmen wie NVIDIA. Sie stellten ihre Produktentwicklung gezielt auf KI-Anwendungen um. Ihre neuen GPU-Generationen waren dafür ausgelegt, die rechenhungrigen Netze und Systeme zu tragen. Dadurch wurde das Training von Modellen schneller, erschwinglicher und weniger zeitaufwendig.

Transformer: Der moderne Durchbruch

Ein himmelweiter Unterschied zu den alten KI-Systemen: Moderne Modelle können sich frühere Eingaben „merken“, Gespräche führen und wirken auf Laien oft tatsächlich intelligent. Möglich wurde das durch Fortschritte wie Recurrent Neural Networks (RNN) und Long Short-Term Memory (LSTM), die ersten grossen Durchbrüche, mit denen Systeme Daten behalten und effizient auf früheren Eingaben aufbauen konnten.

Nachdem die Branche RNNs und LSTMs gemeistert hatte, traten die Transformer auf den Plan – der direkte Vorläufer heutiger Large Language Models (LLMs) und generativer Systeme. Erstaunlich ist, dass diese Architektur erst 2017 mit dem Paper “Attention is All You Need” vorgestellt wurde. Verfasst von Google-Forschern, legte es das Fundament für die Technologie, die wir heute nutzen.

Alle modernen LLMs basieren auf dieser Arbeit. Selbst GPT-3 ist ein direkter Ableger dieser Idee. Ohne Transformer-Architektur sähe die heutige KI völlig anders aus – vermutlich deutlich weniger fortgeschritten. Die Veröffentlichung von GPT-3 im Jahr 2020 fiel nicht nur mit dem neuen Interesse an der Technologie zusammen, sondern befeuerte es sogar. 2021 stiegen die Investitionen auf 119 Milliarden Dollar, und bis 2023 floss rund 30 % davon gezielt in generative KI.

Was diese Geschichte seltsam macht

Betrachtet man die KI-Geschichte als Zeitdiagramm, wirkt sie weder wie eine gerade Linie noch wie ein stetiger Anstieg. Vielmehr gleicht sie einer Achterbahn – mit Zacken, zyklischen Wendungen, tiefen Abstürzen und rasantem Aufstieg. Getrieben wird all das durch neue Forschung, die Stimmung der Öffentlichkeit und die Vorsicht von Investoren.

Aus dieser jahrzehntelangen Entwicklung lassen sich Muster erkennen, die uns helfen, den Fortschritt der Branche besser einzuschätzen. Ein wiederkehrendes Problem: Jeder Schritt nach vorn wird fast sofort als der strahlendste Weg in die Zukunft gefeiert. Meist von der Öffentlichkeit, doch wie bei Rosenblatt überschätzen auch Forscher gelegentlich ihre Möglichkeiten.

Die Folge ist ein rasches Abkühlen der Begeisterung, sobald klar wird, dass viele Ideen nicht mit der aktuellen Technik umsetzbar sind. Wer das Muster der KI-Geschichte studiert, erkennt: Versprechen wurden oft eingelöst – nur eben ein Jahrzehnt zu spät. Ein Warnsignal dafür, dass Ideen in der KI häufig schneller wachsen als die eigentliche Innovationskraft.

Um weitere Wiederholungen und Zusammenbrüche zu vermeiden, können wir ein paar wesentliche Schritte gehen, die die Branche stabilisieren und ein gesundes, massvolles Wachstum fördern. Darauf wollen wir in unseren Schlussgedanken eingehen.

Lektionen für heutige Entwickler

Der Grund, warum wir bis zur Erfindung der KI zurückgehen, liegt darin, dass uns diese lange und komplexe Geschichte hilft, die typischen Fehler im Umgang mit KI zu erkennen. Während die Spezialisten von S-PRO täglich mit KI arbeiten, basiert ihr Erfolg auch darauf, aus den Fehlern ihrer Vorgänger zu lernen. Es geht darum zu verstehen, wie sich KI entwickelt, warum sie ins Stocken gerät und wie weit man sie treiben kann, ohne die Ergebnisse zu gefährden.

Wir möchten, dass Menschen, die für ihre Arbeit oder sogar ihre Existenz auf KI setzen, die wiederkehrenden Muster erkennen, die in der Vergangenheit zu KI-Wintern geführt haben – übertriebene Versprechen und das Nichterfüllen überhöhter Erwartungen. Wer diese Falle vermeidet, kann dazu beitragen, dass die Branche stabil wächst und neue Fähigkeiten erst dann Einzug halten, wenn die Technologie wirklich reif ist.

Der Fortschritt in der KI verläuft nicht Schritt für Schritt, bei dem jede Veröffentlichung automatisch alle anderen beflügelt. Es ist vielmehr ein zyklischer Prozess: Ein Durchbruch erfasst die gesamte Branche – und wenn niemand darauf erfolgreich aufbaut, folgt schnell die Ernüchterung bei Investoren. Deshalb halten wir es für entscheidend, die Denkweise zu ändern und den Blick stärker auf die aktuellen Errungenschaften der KI zu richten.

Wir hoffen, dass unser Überblick über die Geschichte der KI hilfreich und aufschlussreich war und die komplexe, aber inspirierende Entwicklung dieser unverzichtbaren Technologie gezeigt hat. Unsere Begeisterung für KI und unser Anspruch, hochwertige Projekte damit umzusetzen, möchten wir mit anderen in diesem Bereich teilen. Wenn Sie ähnlich denken und ein KI-Projekt besprechen möchten, zögern Sie nicht, uns zu schreiben.

![[Article] The Strange History of AI_ From Perceptrons to Transformers [1626]](https://s-pro.io/wp-content/uploads/2025/09/Article-The-Strange-History-of-AI_-From-Perceptrons-to-Transformers-1626-1200x675.jpg)